Datenpipelines: Der unterschätzte Risikofaktor

Daten sind der Rohstoff, der allen Geschäftsprozessen zugrunde liegt und sie fließen wie Öl durch Pipelines. Meist werden sie über mehrere Schritte vom Quellsystem zum Zielsystem verschoben: Sie werden kopiert, in die Cloud übertragen oder auch mit anderen Datenquellen kombiniert. Diese Pipelines und die damit verbundenen Prozessschritte sind ein vielfach unterschätztes Sicherheitsrisiko.

Sicherheitsexperten wissen, dass ein Sicherheitssystem nur so stark ist, wie sein schwächstes Glied. Spätestens während der Corona-Pandemie haben IT-Teams die Infrastruktur für den Fernzugriff verbessert und begonnen IAM-Dienste (Identity & Access Management) verstärkt einzusetzen. Und auch andere Maßnahmen zur Absicherung werden heute regelmäßig durchgeführt. Dazu gehören regelmäßiges Patchen genauso wie Back Ups und anderes mehr. Oftmals wenig Aufmerksamkeit dagegen erhalten intern entwickelte Datenpipelines. Aber gerade auch diese stellen eine der Schwachstellen dar, die zu erheblichen Datenschutzverletzungen und Betriebsunterbrechungen führen können. Datenpipelines werden für den heutigen Geschäftsbetrieb immer wichtiger, da sie die Bewegung und Verarbeitung sensibler Informationen erleichtern und jede Unterbrechung der Pipeline oder jede Verletzung der Datenintegrität erhebliche Auswirkungen auf das Geschäft haben kann.

Die Datenintegrationsspezialisten haben bereits Fälle erlebt, in denen selbst gehostete Pipelines Tausende von Anmeldeinformationen von Apache Airflow preisgegeben haben, weil sie falsch konfiguriert waren, fest codierte Passwörter enthielten und nicht auf dem neuesten Stand der Sicherheitsupdates waren. Eine Pipeline speichert zwar keine sensiblen Daten, greift aber für Backups, Datensynchronisationen und andere Datentransfers auf sensible Daten zu. Wenn ein Hacker Zugang zu einer Pipeline erhält, kann er sofort damit beginnen, Daten zu überwachen oder zu extrahieren, ohne dass ein Sicherheitsteam dies bemerkt.

Kunden- und öffentlich zugängliche Systeme erhalten die meiste Aufmerksamkeit in Bezug auf Sicherheit, einschließlich Sicherheitsaudits, Pen-Tests und Design Reviews. Dies liegt daran, dass diese Systeme sehr sichtbar und für die Unternehmen von entscheidender Bedeutung sind. Datenpipelines sind weniger sichtbare, aber ebenso wichtige Systeme: Wenn ein Unternehmen seinen Pipelines nicht die gleiche Aufmerksamkeit schenkt wie seinen Produktionssystemen, sind sie sehr gefährdet. Der Solar Winds Hack, die Log4j-Sicherheitslücke oder der 3CX-Trojaner zeigen, dass Supply-Chain-Angriffe schwerwiegend sein können, und oft enorme Wirkung und Ausmaße annehmen. In den USA hat man schon 2021 eine entsprechende Executive Order erlassen, die unter anderem festlegt, wie Unternehmen ihre Anwendungen auf Schwachstellen überprüfen müssen und wie diese zu handhaben sind.

Begehrtes Ziel von Hackern: Interne Datenpipelines

Intern entwickelte Datenpipelines sind für Hacker besonders attraktiv, da sie Zugang zu sensiblen Daten bieten. Darüber hinaus werden sie häufig außerhalb der Routineprozesse gewartet und die internen Sicherheitsteams sind sich des Risikos möglicherweise nicht einmal bewusst, geschweige denn verfügen sie über die Instrumente zur Überwachung von Datenlecks in einer internen Pipeline.

Wenn Datenpipelines außerhalb der eigentlichen Softwareentwicklungsteams von Analysten oder IT-Support-Teams (oder noch schlimmer, als “Shadow-IT”) gewartet werden, können unterschiedliche Budgets, Prioritäten und Verfahren zu Lücken in der Sicherheit der gesamten Infrastruktur führen. Wenn Pipelines von IT-Generalisten gewartet werden, erhöht sich das Risiko, dass eine falsch konfigurierte Einstellung oder ein fest codiertes Passwort zu einer Gefährdung führt. Darüber hinaus ist es aufgrund der Natur einer Datenpipeline nicht leicht zu erkennen, ob ein böswilliger Akteur den Datenfluss überwacht und im Laufe der Zeit einfach Informationen abschöpft.

Pipeline Security: So geht sichere Datenintegration

Um solche unbemerkten Pipeline-Hacks zu verhindern, sollten Unternehmen für ihre Datenpipelines dieselben Sicherheitsverfahren anwenden, die SaaS-Unternehmen zum Schutz ihrer Kundendaten einsetzen. In einer vernetzten Welt ist die Mentalität des “Einstellen und dann Vergessens” überholt.

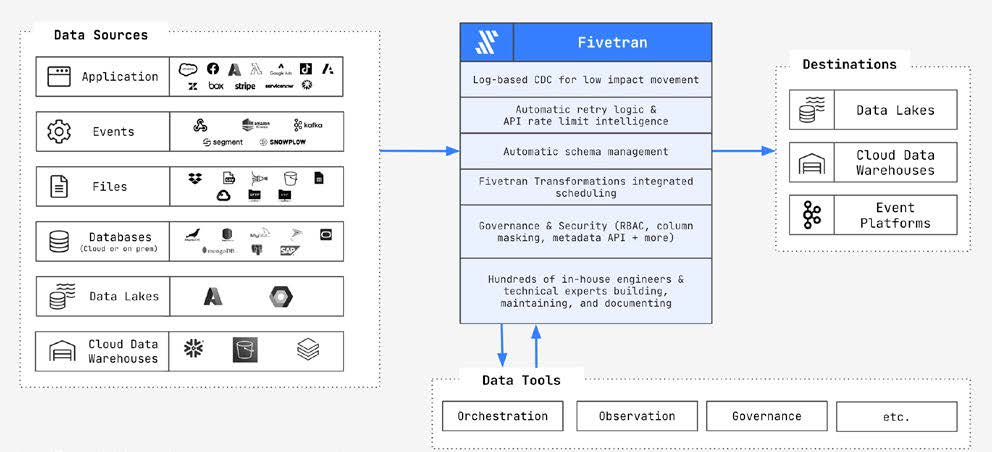

Der Arbeitsaufwand für die Sicherung interner Datenströme und Server vor Ort ist für ein Unternehmen mit 50 Mitarbeitern ungefähr genauso hoch wie für ein Unternehmen mit 5.000 Mitarbeitern. Das bedeutet, dass die meisten kleineren und mittelständischen Unternehmen diesen Aufwand nicht betreiben, es sei denn, sie nutzen einen SaaS-Ansatz. Ein solcher Ansatz braucht eben nicht die Kompetenz und Ressourcen, die Unternehmen sonst intern aufbauen und bereithalten müssten. Das bedeutet auch die ELT-Prozesse werden in einer Pipeline als eigener Service entsprechend ausgeführt. Zu den Vorteilen einer Managed Pipeline gehören automatisches Patching, verschlüsselte Speicherung von Anmeldeinformationen, laufende Penetrationstests und mehrfache Compliance-Audits.

Einer der ersten Schritte, um die Sicherheit der Datenpipelines zu erhöhen, ist der Einsatz von Sicherheitsüberprüfungs-/Konfigurationsmanagement-Tools der Cloud-Anbieter, wie AWS Trusted Advisor. Diese Tools können nach häufigen Fehlern suchen und die Einhaltung der Best Practices der Branche sicherstellen. Darüber hinaus sollten Unternehmen regelmäßige Audits und Überprüfungen zur Erkennung von Fehlkonfigurationen sowie jährliche Pen-Tests einplanen. Der Einsatz einer Managed Pipeline kann den Verwaltungsaufwand reduzieren und gründliche Tests gewährleisten.

Es ist immer wichtig, sich über Sicherheitspatches und -updates auf dem Laufenden zu halten, aber veraltete Software kann leichter übersehen werden, wenn sie nur auf internen Systemen läuft. Angesichts der zahlreichen Angriffe über die Software Supply Chain sind eine ständige Überwachung und Patches erforderlich, um Schwachstellen zu beseitigen. Die kürzlich angekündigten Supply-Chain Levels for Software Artifacts (SLSA) Version 1.0 sollen helfen, Softwarecode vor Manipulation zu schützen und sichere Entwicklungspraktiken zu erleichtern. Nichtsdestotrotz sind ständige Überwachung und Patching zur Beseitigung von Schwachstellen in externen und internen Diensten unerlässlich.

Ein weiterer übersehener Aspekt von selbst gehosteten Pipelines ist ihre Architektur. Sichere Architekturen definieren eine Hauptfunktion pro Server oder Container. Für den Zahlungsverkehr und die Abwicklung von Kreditkartentransaktionen verlangt zum Beispiel PCI DSS dies als Teil einer sicheren Konfiguration und Robustheit. Die meisten selbst gehosteten Pipelines werden als ein einziger Server oder Container ausgeführt, um die Verwaltung zu vereinfachen. Dies stellt ein Risiko dar, wenn eine Komponente des Dienstes (z. B. Log4j) eine Schwachstelle aufweist, denn ein Angreifer kann sich leicht überall im System bewegen. Eine sichere Pipeline trennt die Verwaltungsoberfläche der Webanwendung von der Datenbank, in der die Synchronisierungseinstellungen gespeichert sind, und von den Konnektoren, die Daten synchronisieren. Mit der richtigen Isolierung können Administratoren das System sichern, indem sie die Möglichkeiten der einzelnen Komponenten einschränken und beim Auftreten von Anomalien Alarm schlagen.

IT-Sicherheitsexperten müssen erkennen, wie wichtig die Sicherung von Datenpipelines in einer datengesteuerten Unternehmensumgebung ist. Durch die Anwendung umfassender Sicherheitspraktiken, die Nutzung von Managed-Pipeline-Lösungen und die Implementierung robuster architektonischer Kontrollen können Unternehmen ihre Daten-Pipelines effektiv absichern. Auf diese Weise können Unternehmen ihre allgemeine Sicherheitslage erheblich verbessern und sensible Informationen vor potenziellen Verstößen und Störungen schützen.