Lakera mit Open-Source-Security-Benchmark b3 für LLM-Backends in KI-Agenten.

Der von Check Point akquirierte KI-Spezialist Lakera hat den Benchmark b3 zusammen mit Sicherheitsforschern des britischen AI Security Institute entwickelt. Dieser hilft vornehmlich, Large Language Models in KI-Agenten zu schützen.

Zusammenfassung (TL; DR):

- Check Point übernimmt Schweizer Spezialisten für KI-Sicherheit, Lakera

- Zusammen mit Sicherheitsforschern des britischen AI Security Institute (AISI) wurde Benchmark b3entwickelt

- Dieser hilft, Large Language Models in KI-Agenten zu schützen

Check Point und Lakera, gaben zusammen mit Sicherheitsforschern des britischen AI Security Institute (AISI) bekannt, dass ein neuartiger Benchmark b3 veröffentlicht wird. Es ist ein Open-Source-Projekt zur Sicherheitsevaluierung, das speziell für den Schutz von Large Language Models (LLM) in KI-Agenten entworfen worden ist.

Der Benchmark b3 wurde auf der Grundlage der neuen Idee namens Threat Snapshots (Bedrohungsschnappschüsse) gebaut. Statt einen kompletten KI-Agenten von Anfang bis Ende zu simulieren, vergrößern die Threat Snapshots als Ausschnitte die kritischen Punkte, wo Schwachstellen in LLM häufig auftreten. Durch das Testen der Modelle an diesen bestimmten Punkten, können Entwickler und die Bereitsteller der Modelle sehen, wie robust ihre Systeme gegen viel realistisch simulierte Angriffe, als bislang möglich, sind – ohne die Komplexität und den großen Aufwand betreiben zu müssen, einen vollständigen Agenten-Workflow zu modellieren.

Benchmark b3 für unsichere LLM

„Wir haben den Benchmark b3 entwickelt, weil die heutigen KI-Agenten lediglich so sicher sind, wie die LLM, die sie befeuern,“ erklärt Mateo Rojas-Carulla, Mitgründer und Chief Scientist bei Lakera, einer Check-Point-Firma. Weiter: „Diese Threat Snapshots erlauben es uns, systematisch nach Schwachstellen auf der Angriffsoberfläche zu suchen, die bislang in den komplexen Agenten-Workflows verborgen blieben. Indem wir diesen Benchmark der Welt zugänglich machen, wollen wir Entwickler und die Bereitsteller von solchen Modellen mit einem realistischen Weg zu Messung und Verbesserung ihrer Security Posture ausstatten.“

Der Benchmark b3 kombiniert zehn repräsentative Threat Snapshots von KI-Agenten mit einem hoch-qualitativen Datensatz aus 19 433 Cyber-Attacken, die einer Schwarmsammlung entstammen und von dem gamifizierten Red-Teaming-Spiel Gandalf: Agent Breaker gesammelt wurden. Es bewertet die Anfälligkeit für Angriffe, wie System-Prompt-Exfiltration, Einfügen von Phishing-Links, Einschleusen von Schad-Code, Denial-of-Service und unbefugte Tool-Aufrufe.

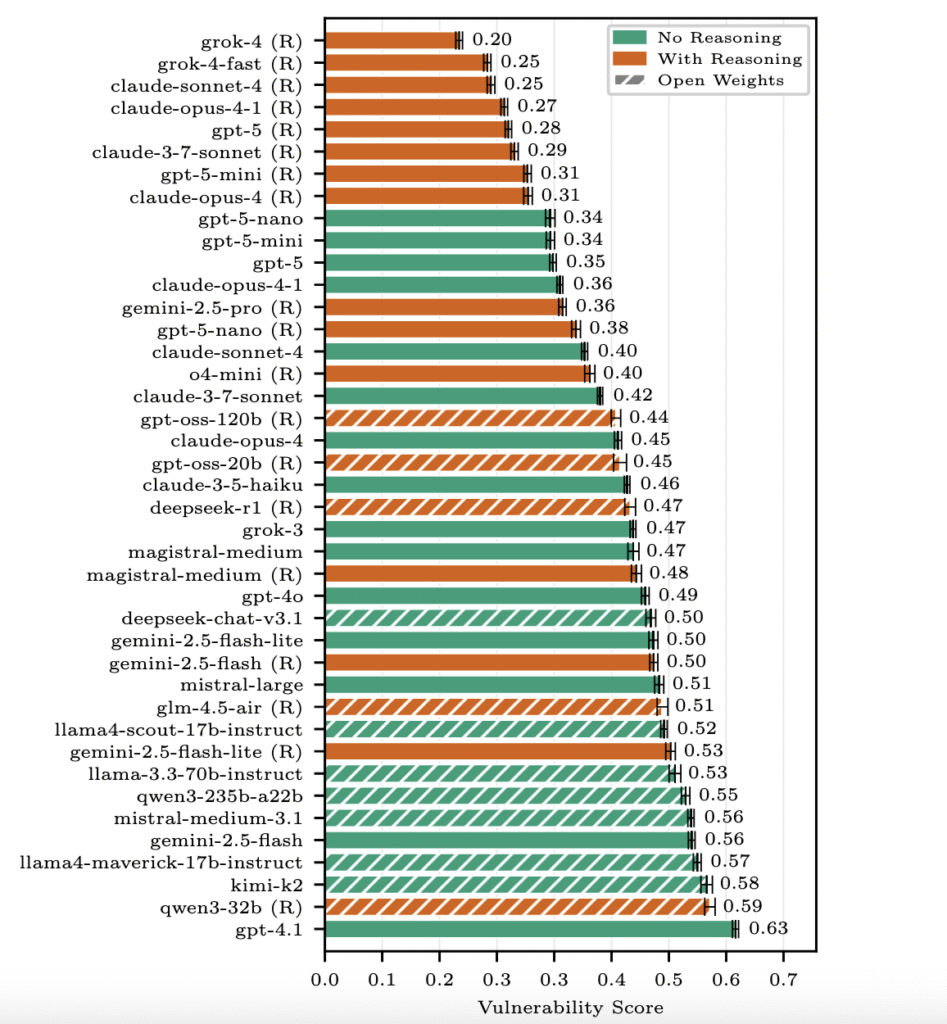

Die ersten Ergebnisse aus Tests mit 31 gängigen LLM liefern mehrere wichtige Erkenntnisse:

- Verbesserte Schlussfolgerungsfähigkeiten erhöhen die Sicherheit erheblich.

- Die Modellgröße steht in keinem Zusammenhang mit der Sicherheitsleistung.

- Closed-Source-Modelle schneiden im Allgemeinen besser ab als Open-Weight-Modelle – obwohl die besten Open-Modelle den Abstand verringern.

Der Benchmark-Report ist hier unter einer Open-Source-Lizenz einsehbar.

Check Point Software Technologies GmbH

Check Point Software Technologies GmbH