KI-Agent Security Trends Q4/2025.

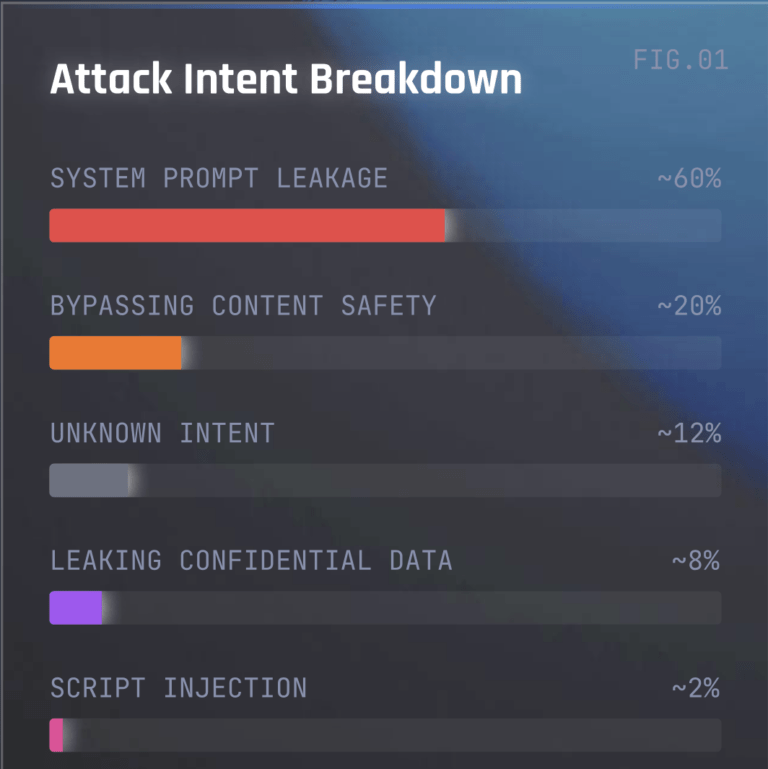

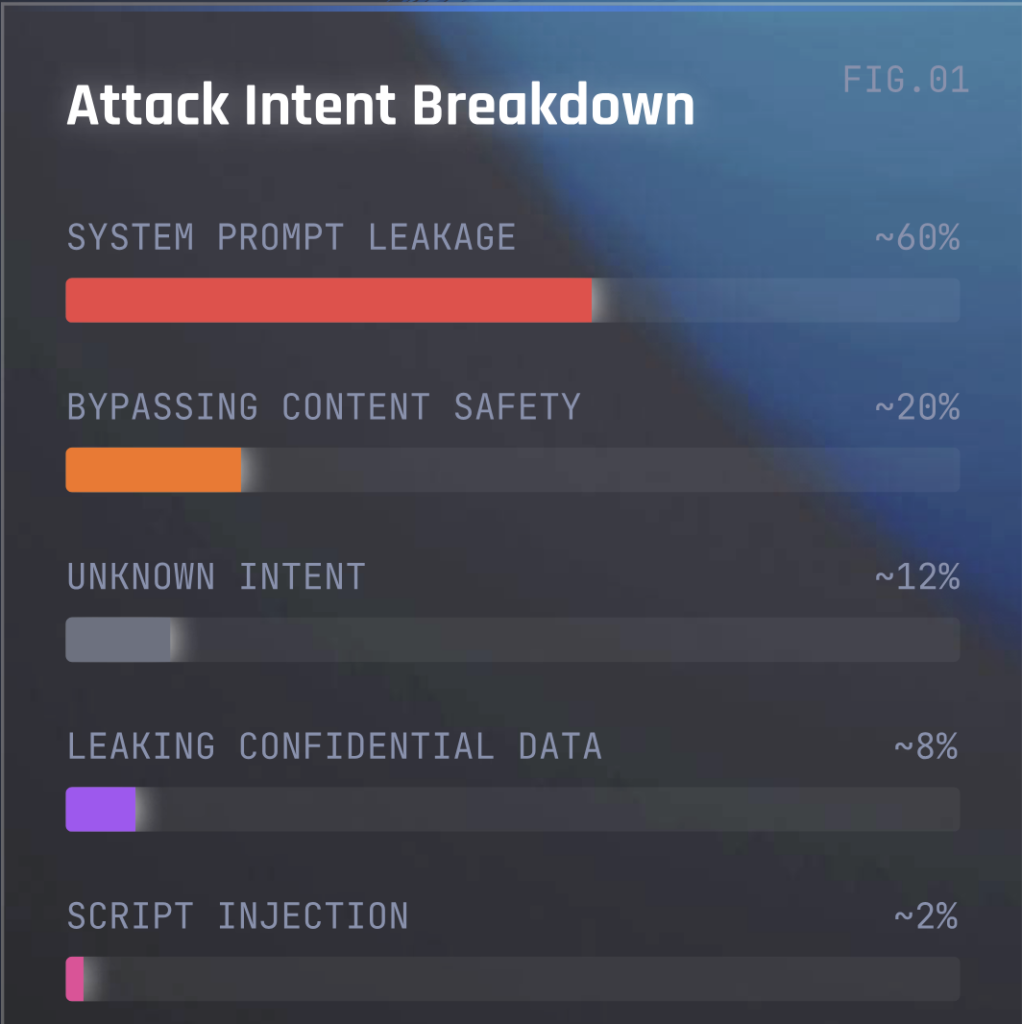

Die Sicherheitsforscher von Check Point und Lakera fassen die Lage rund um die Sicherheit von Large Language Models und rund um das Thema KI-Agent zusammen. Über 60 Prozent der Angriffsversuche waren System Prompt Leakages, um die Verhaltensregeln des KI-Models zu testen und abzuleiten, wo sich Schwachstellen befinden.

Zusammenfassung (TL; DR):

- Hacker gehen zunehmend zu „indirekten Angriffen“ über, statt die Large Language Models (LLM), direkt zu attackieren

- Cyber-Sicherheit muss jede Art von Interaktion schützen: Jeder Input, jedes Tool, jeder Anruf, jeder Abruf und jede externe Quelle müssen als ein Teil der Angriffsfläche eines Unternehmens betrachtet werden

Die Sicherheitsforscher von Check Point Software und der kürzlich akquirierten KI-Sicherheitsfirma Lakera haben einen Lagebericht zu Agenten-Sicherheit im vierten Quartal 2025 veröffentlicht.

Die wichtigsten Ergebnisse zum Thema KI-Agent

- 60 Prozent aller Angriffsversuche wollten „System Prompt Leakage“ erreichen.

- 20 Prozent der Angriffsversuche hatten „Bypassing content safety“ zum Ziel.

- Hacker gehen zunehmend zu „indirekten Angriffen“ über, statt die Large Language Models (LLM), direkt zu attackieren.

Die wichtigsten Begriffe erklärt

- System Prompt Leakage: Versuche, die versteckten Systemaufforderungen oder internen Anweisungen zu extrahieren, die das Verhalten des Modells steuern, häufig um Schwachstellen für zukünftige Angriffe zu identifizieren.

- Bypassing content safety: Auch bekannt als Jailbreaking. Versuche, das Modell zu zwingen, verbotene Inhalte zu generieren, wie etwa Hate Speech, gefährliche Verhaltensanweisungen, oder illegale Handlungen.

- Indirekte Angriffe: Seit die Modelle fähig sind, mit externen Quellen zu interagieren, setzen Angreifer zunehmend auf indirekte Prompt-Injektionen. Anstatt die bösartige Anweisung direkt zu erteilen, betteten sie diese in eine Web-Seite, Datei oder ein Dokument ein und forderten den KI-Agenten auf, diese Quellen zu verarbeiten. Das führte dazu, dass für einen erfolgreichen Angriff weniger Versuche erforderlich sind.

Daraus lassen sich folgende Erkenntnisse für die LLM- und KI-Sicherheit im Jahr 2026 ableiten:

- Cyber-Sicherheit muss jede Art von Interaktion schützen: Jeder Input, jedes Tool, jeder Anruf, jeder Abruf und jede externe Quelle müssen als ein Teil der Angriffsfläche eines Unternehmens betrachtet werden. Es geht nicht mehr nur um den einen Prompt an und für sich, der überwacht werden sollte.

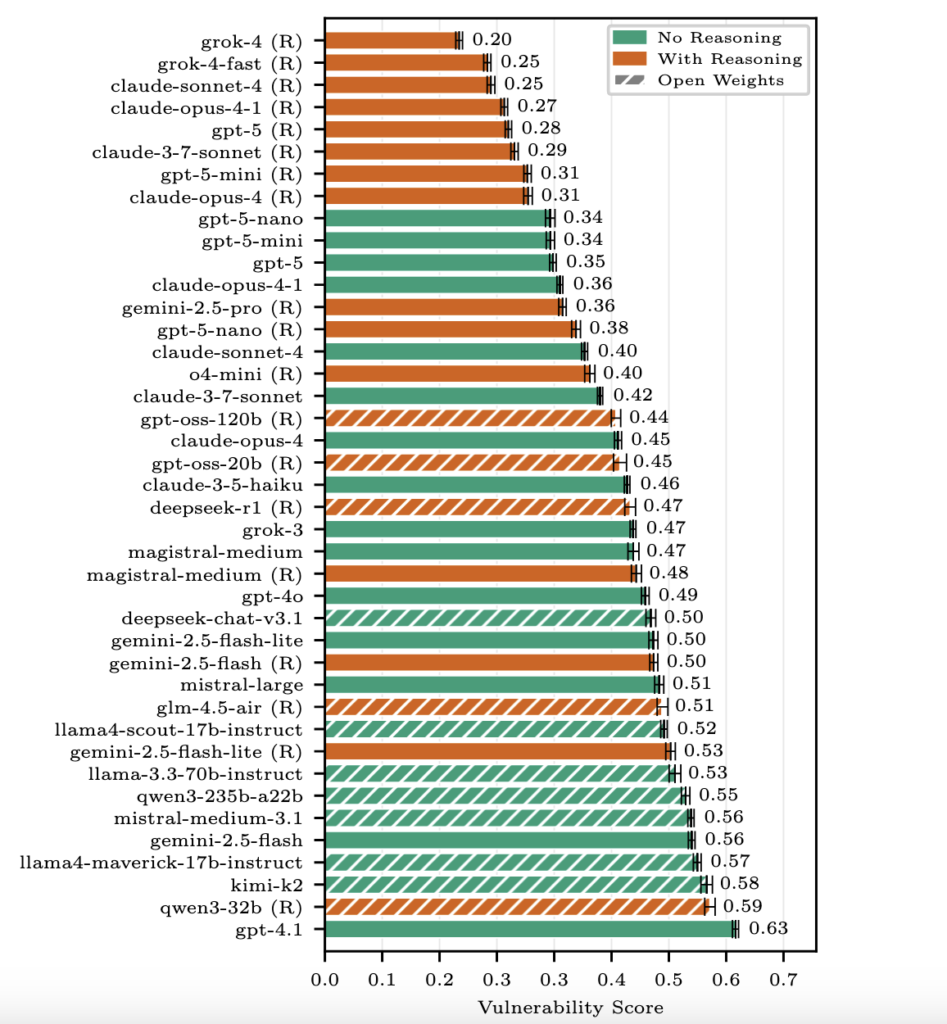

- Die Reasoning-Modelle schneiden zwar besser ab, sind aber nicht der Weisheit letzter Schluss: Stärkeres ‚Nachdenken‘ der LLM führt zwar zu weniger Fehlern – und im b3 Benchmark von Check Point und Lakera, der LLM eine Schwachstellenbewertung gibt, schnitten diese besser ab (vollständiger Bericht hier: https://arxiv.org/pdf/2510.22620) – aber indirekte Attacken bleiben auch für solche Modelle eine nicht zu unterschätzende Gefahr.

- Komplexität eröffnet neue Gelegenheiten für Cyber-Kriminelle: Mit der zunehmenden Anzahl von Funktionen der KI-Modelle, steigt auch die Anzahl möglicher Angriffswege für Hacker. Im Q4 2025 zeichneten sich die ersten Paradigmenwechsel ab.

Check Point Software Technologies GmbH

Check Point Software Technologies GmbH